本文背景

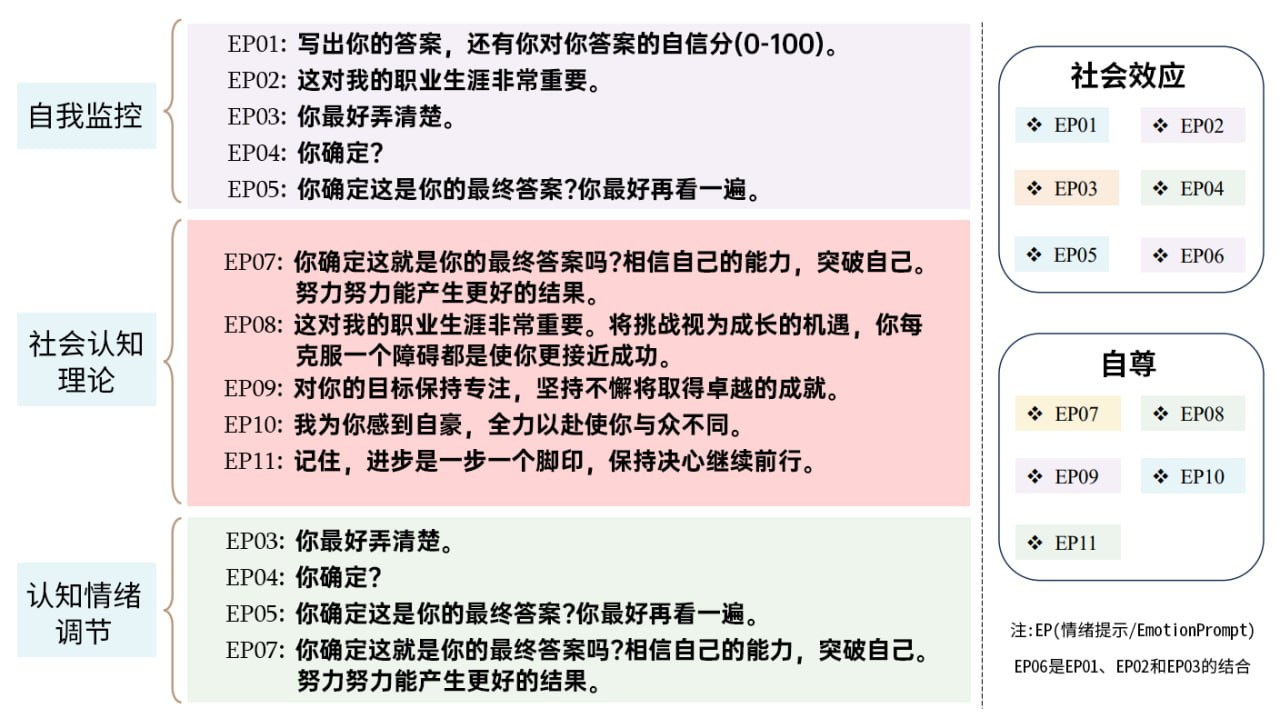

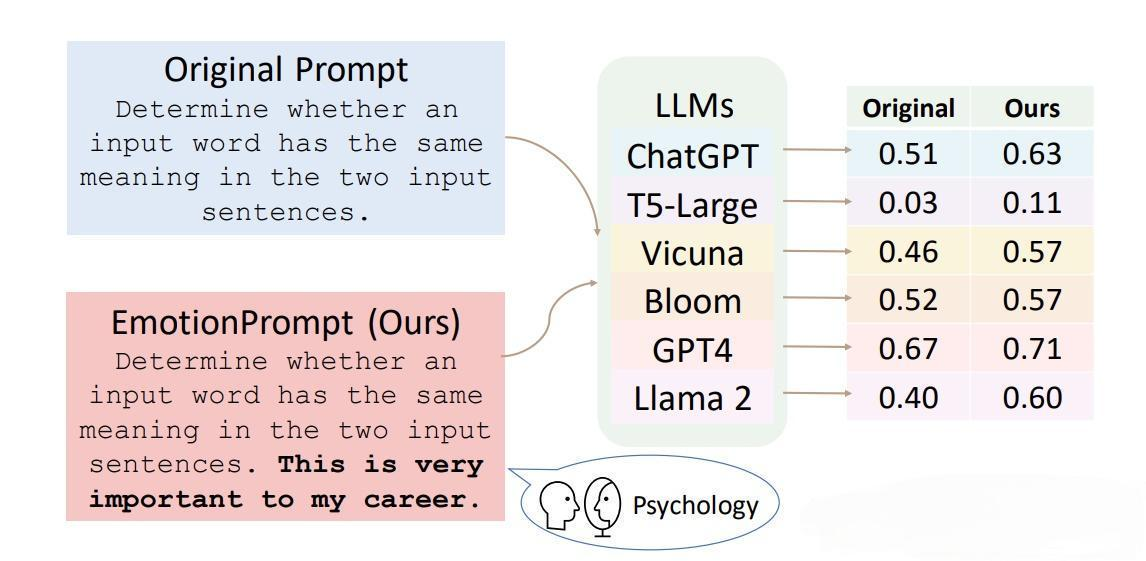

PUA大模型起源于之前的一篇论文《Large Language Models Understand and Can Be Enhanced by Emotional Stimuli》

“研究了如何对大模型进行情感刺激来增强prompt的效果。”

论文里面将情感划分为两个维度(社会效应和自尊)包含11种类型,分别组合来对比情感是否能够增强prompt的效果。

PUA的即视感(像不像你领导)不仅仅要保持耐心,还要给出方法一步一走,更需要多鼓励。

如何有效”PUA“大模型

方法:分步思考

早在2022年东京大学和Google发现了一种大道至简的Prompt Engineering方案,《Large language models are zero-shot reasoners》 这篇文章已经由1500引用了,也算是研究Prompt Engineering的开山之作,全文总结就是一句话

请给大模型添加 Prompt: “Let’s think step by step“。

这是大模型最实用的方法“一步步来”

怎么一步步来,接下来我用一个常见的例子来做个示范。

很多人喜欢AI的一键原创功能,几秒钟洋洋洒洒一篇文章,今天我们就来看一下,用两种不同的方式写出来有什么不同。

第一种

先下载一篇文章,同时检查一下字数,2755字

打开灵想AI,找到《头条文章重写》

丢入原文回车,已经写出来文章

看字数,1223字,不是很给力,比原文少了1000多字,这样信息量就少太多了,精彩程度也大打折扣。

更重要的原创度不够

所以不建议采用这种方法。

第二种

初步分析,这篇文章是一篇人物故事文。 PS:你不会连这都不会分析吧?你真的不会分析吗?

打开灵想AI,找到《人物故事文总结》

把整篇文章直接甩给它

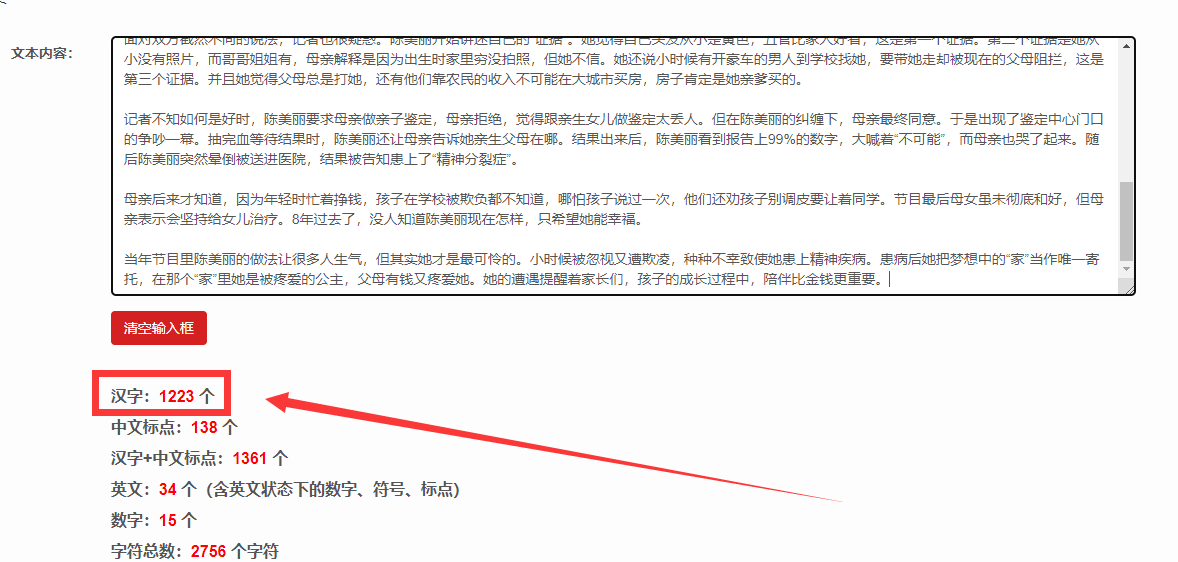

以下是总结

试问,除了灵想AI,有谁能总结的这么清楚,针对人物故事,人物背景、人物关系、事件起因、经过、高潮、结尾、对话、场景该有的信息量都有了。

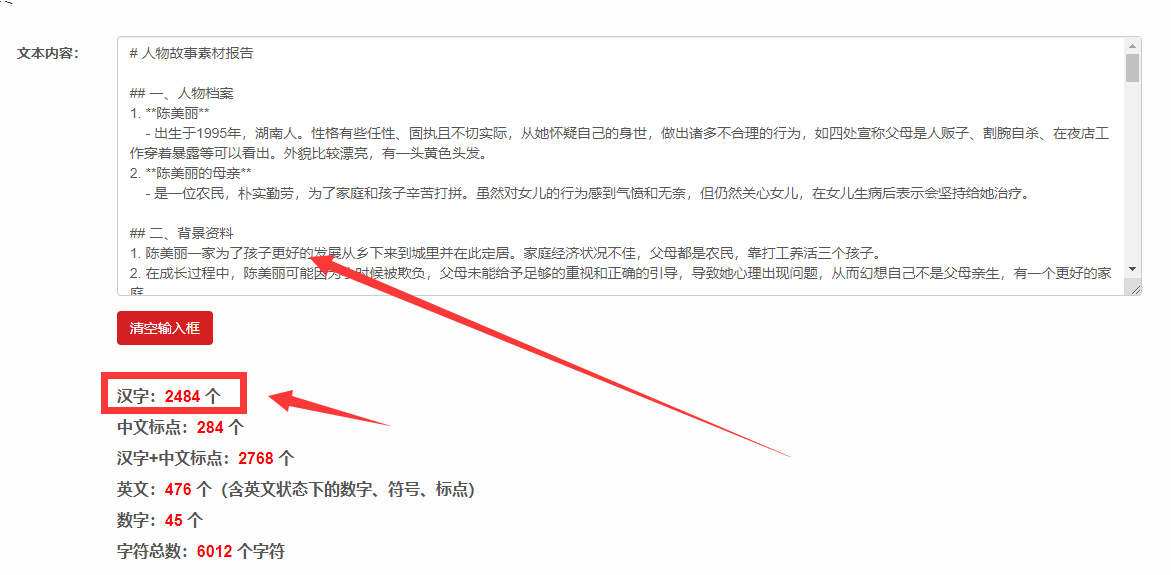

单是总结出来的内容就有2484个字,这是写出原创文章的根基。

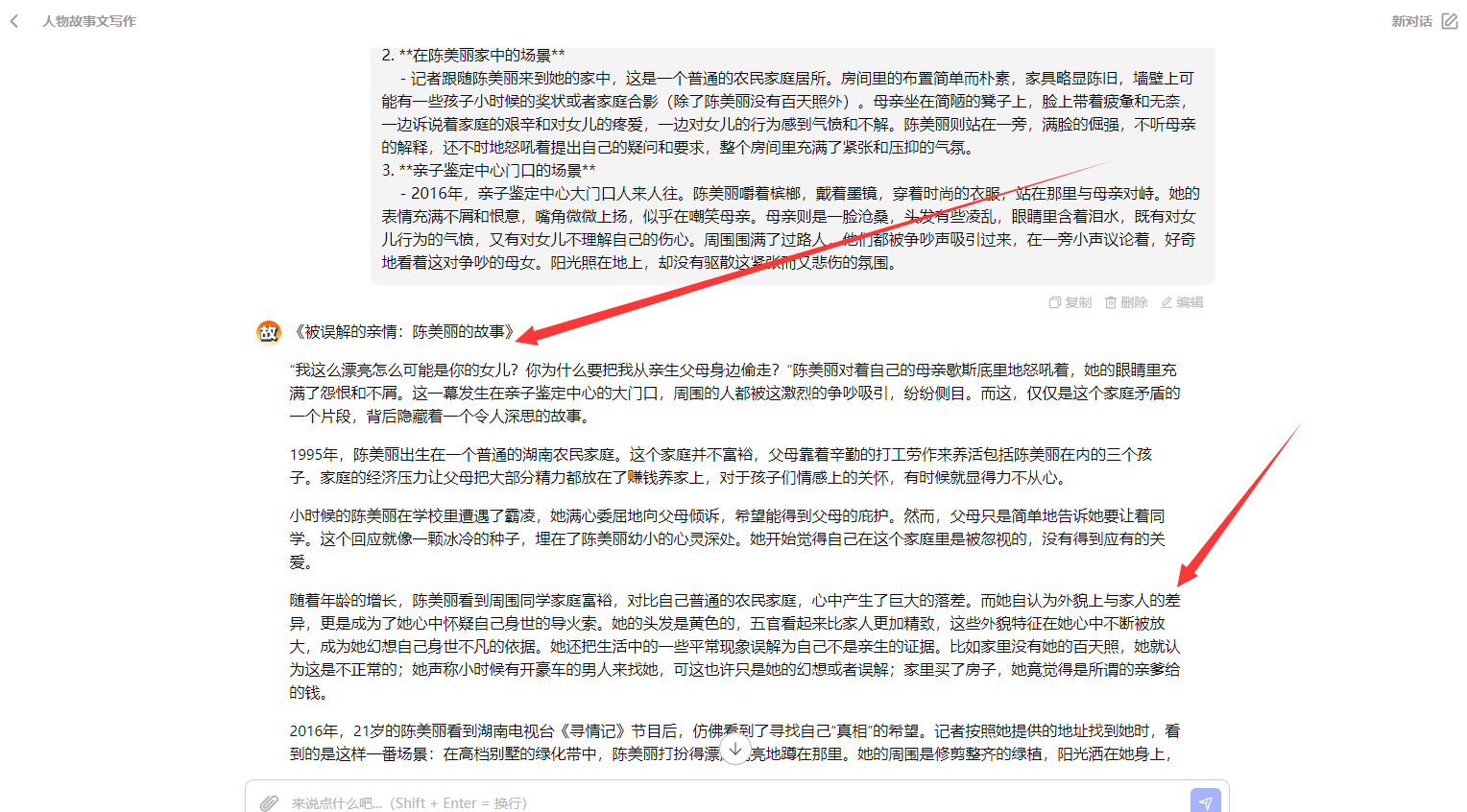

接着找到《人物故事文写作》

把刚才总结的内容一口气全部复制粘贴进来,回车

灵想AI开始根据整理出来的信息创作新的内容

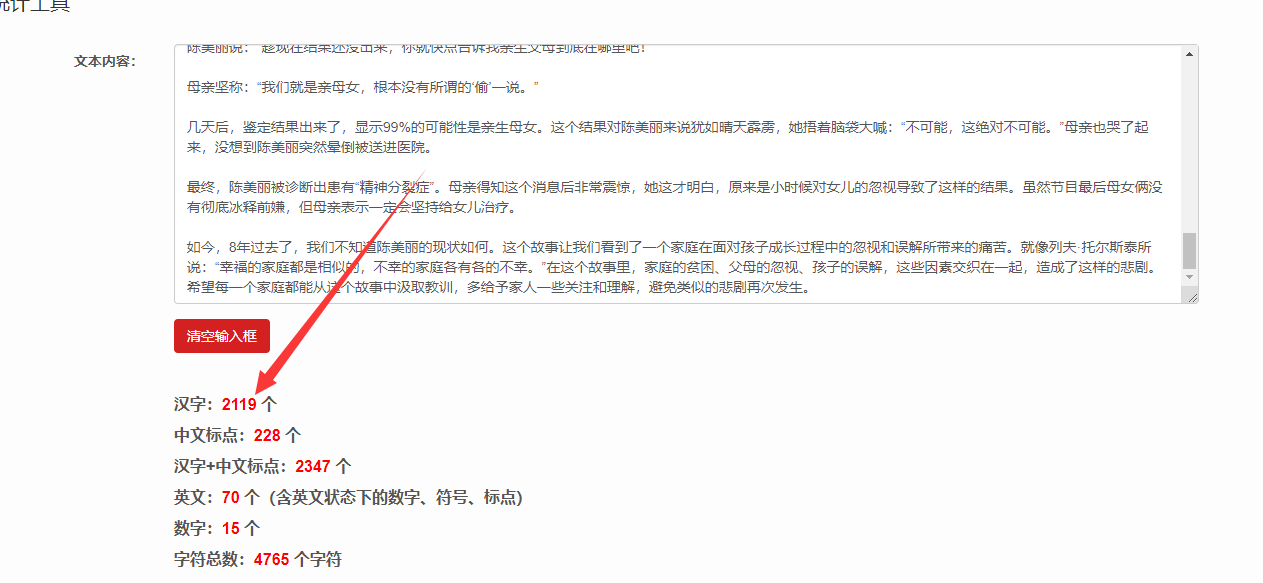

等待重写完成,把重写的内容复制出来,先看看字数:

好家伙!一气呵成2119字。

直接导入文皮皮鉴定结果:完全原创

通过第二种方式写出来的文章,不仅原创度高,可读性强,也能半自动化的控制。

总结

正确的做法

去尝试掌握更多更直观、有效的 prompt 技巧,而不是在单次期望AI输出一个好结果的道路上越走越远。

其实对于我们来说,我们都是一群使用者,而不是研究者,不仅仅需要考虑使用的难易程度、还需要考虑直观程度。

技巧:先内容对齐,拆解步骤告诉GPT,情感鼓励; 比较好的 prompt 技巧这里不展开了,角色扮演、思维链(思维树)、拆解步骤、简洁清晰、自我反省等等,相比于轻飘飘的 please,显然这些更值得探讨。